付费升级 AI 前必看!4 个灵魂拷问,让你别花冤枉钱

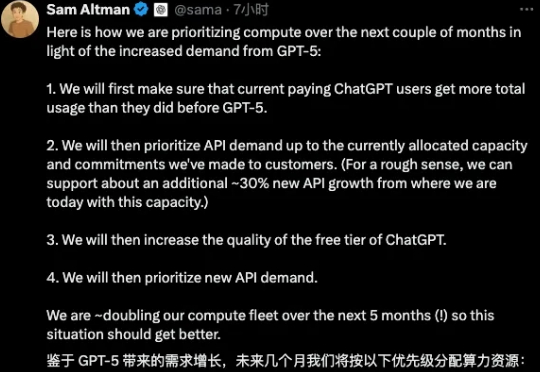

付费升级 AI 前必看!4 个灵魂拷问,让你别花冤枉钱上周 GPT 5 的更新,除了激起对 4o 的想念,还激起了对 OpenAI 刀法的埋怨:优先付费用户,优先 API 支持…… 说吧,奥特曼,是不是就想逼我花钱升级?

上周 GPT 5 的更新,除了激起对 4o 的想念,还激起了对 OpenAI 刀法的埋怨:优先付费用户,优先 API 支持…… 说吧,奥特曼,是不是就想逼我花钱升级?

OpenAI 发布了 GPT-5,我在公众号里、社群里、论坛里,很多地方都在刷屏一个消息:GPT-5 来了,而且在编程能力上“强得可怕”。

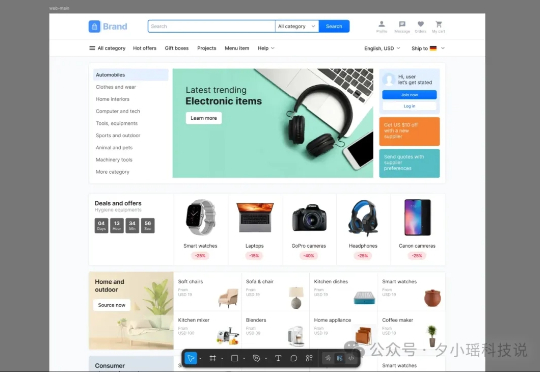

人不能同时踩两个坑,但 OpenAI 做到了。 GPT-5 发布会上,OpenAI 因为一张比例失调的图表被全网群嘲。后续他们火速更新图表,目前已经调整好了比例。

一觉醒来,OpenAI 的大模型又完成了一项壮举!在全球顶级编程赛事之一 ——2025 年国际信息学奥林匹克(IOI)中,OpenAI 的推理模型取得了足以摘得金牌的高分,并在 AI 参赛者中排名第一!

软银集团作为买方接手了富士康科技集团在俄亥俄州的电动汽车工厂,此举旨在推动这家日本公司与OpenAI 及甲骨文公司,合作的 5000 亿美元"星际之门"数据中心项目。

GPT-5 上线之后,吐槽声一片。眼看舆论越来越不对劲,今天凌晨 OpenAI CEO 山姆·奥特曼(Sam Altman)紧急出来救火,发长文回应各种吐槽。

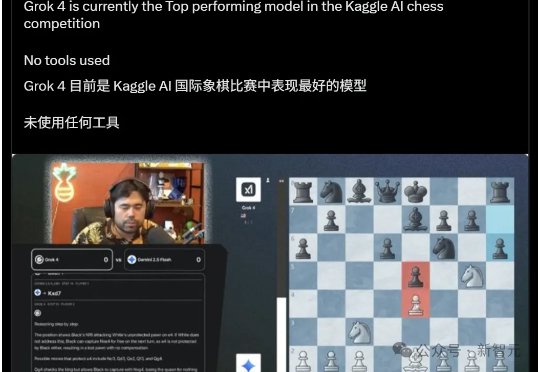

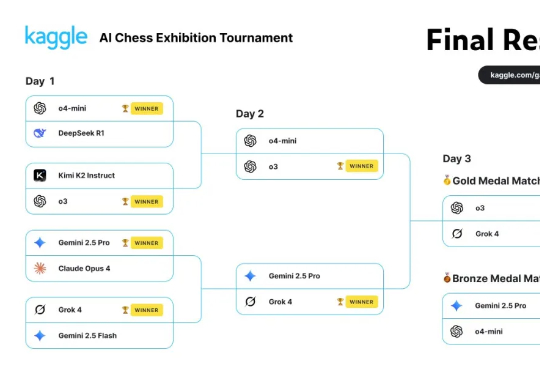

决赛前,它是沉默、精准、不可一世的冠军候选;决赛后,它成了连续送子、失误连连的背景板。Grok 4经历了从神坛到谷底的戏剧性一天,它的轰然倒塌,也成就了o3的不败王者神话。

备受 AI 圈关注的首届谷歌 Kaggle AI Chess 大赛(也即大模型国际象棋对抗赛)迎来了最终赢家。就在昨天,Grok 4 携手 OpenAI o3 进入了决赛。在机器之心的投票中,大家更倾向于 o3 战胜 Grok 4。

昨天是个热闹的日子,OpenAI 和 Anthropic 几乎在同一时间发布了自家的新款模型:前者是自 GPT-2 以来重新开源的两款模型 gpt-oss(120b 和 20b),后者是 Claude 系列最强的 Opus 4.1。

明天,Grok 对阵 OpenAI 的 o3。 谁也没想到,谷歌攒的 Kaggle AI Chess 比赛(即大模型国际象棋对抗赛),在半决赛中,Grok 4 击败 Gemini 2.5 Pro,进入总决赛!